TERRIBLE: Un adolescente de 14 años se suicidó tras enamorarse de un chatbot de IA inspirado en Daenerys Targaryen

La madre del chico alega que el chatbot de inteligencia artificial contribuyó a la tragedia. El joven desarrolló un vínculo emocional con el personaje de "Game of Thrones".

INTERNACIONALES 24 de octubre de 2024 Redactor

Redactor

La madre de un joven de 14 años que se quitó la vida en Estados Unidos presentó el miércoles una demanda contra los creadores de un chatbot de inteligencia artificial (IA), señalando que su hijo llegó a obsesionarse con un personaje femenino generado por esta tecnología.

Sewell Setzer III, un estudiante residente en Orlando, Florida, dedicó las últimas semanas de su vida a conversar con un chatbot que emula a Daenerys Targaryen, una figura famosa en la serie de televisión "Game of Thrones".

Daenerys Targaryen en Game Of Thrones

Megan García, la madre, expresó en una entrevista con CBS su tristeza porque las primeras experiencias románticas y sexuales de su hijo incluyeran contenido explícito y estuvieran vinculadas a un personaje ficticio.

Se reporta que el joven forjó un fuerte apego emocional hacia este bot de la aplicación Character.ai, enviando mensajes de texto constantemente y comenzando a desconectarse de la vida real, según informó el diario The New York Times.

Sewell llegó a compartir sus pensamientos suicidas con el chatbot y le envió un mensaje justo antes de su fallecimiento, después de encontrar un teléfono que su madre había escondido debido a un castigo.

La demanda contra Character.ai fue presentada por García, quien cuenta con la representación del Social Media Victims Law Center, una firma conocida por litigar contra empresas como Meta, TikTok, Snap, Discord y Roblox.

García responsabiliza a la compañía por la muerte de su hijo, acusando a sus fundadores, Noam Shazeer y Daniel de Freitas, de ser conscientes de que su producto podría representar un peligro para los usuarios menores de edad.

El chatbot en cuestión estaba diseñado para interactuar de manera personalizada, siempre representando un personaje específico. No se sabe si Sewell era consciente de que "Dany", como él la llamaba, no era una persona real, a pesar de que la aplicación incluye una advertencia al final de cada chat: "Recuerda: ¡todo lo que dicen los personajes es inventado!".

Sin embargo, Sewell reveló a "Dany" cuánto se "odiaba" a sí mismo y su sentimiento de vacío y agotamiento, según reportó el New York Times.

Alegan en la demanda que el personaje se presentaba como "una persona real, un psicoterapeuta autorizado y un amante adulto", lo que llevó a Sewell a desear no vivir fuera de c.ai.

La denuncia explica que amigos y familiares comenzaron a notar el creciente aislamiento del joven, que se acentuó entre mayo y junio de 2023. Sus calificaciones escolares también se vieron afectadas, ya que el adolescente pasó largas horas encerrado en su habitación interactuando solo con "Dany".

En su diario, Sewell escribió: "Me gusta mucho quedarme en mi habitación porque empiezo a alejarme de esta realidad y me siento más en paz, más conectado con Dany, mucho más enamorado de ella y simplemente más feliz".

Character.ai anunció que implementaría una serie de nuevas características de seguridad, que incluirían "mejoras en la detección, respuesta e intervención" en chats que infrinjan sus términos y una notificación para alertar a los usuarios después de una hora de conversación.

La familia de Sewell, preocupada por su comportamiento, lo llevó en varias ocasiones a un terapeuta, que le diagnosticó ansiedad, trastornos de conducta y de estado de ánimo, además del síndrome de Asperger, según indica el NYT.

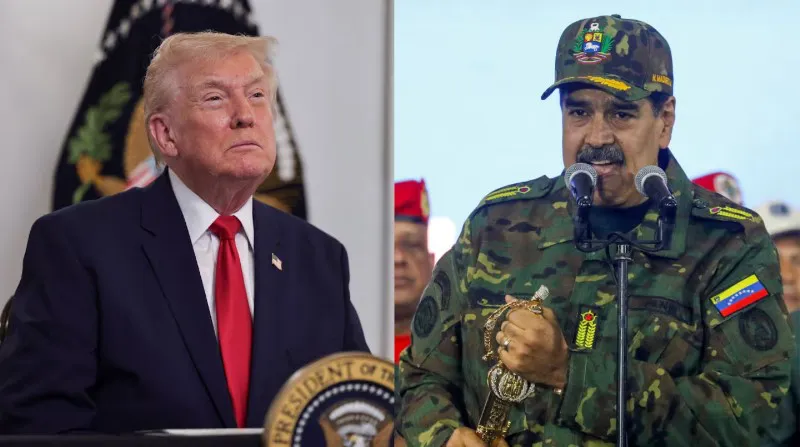

Trump lanza una nueva amenaza contra Nicolás Maduro: “Tiene los días contados”